Grok技术原理揭秘:背后的AI逻辑解析

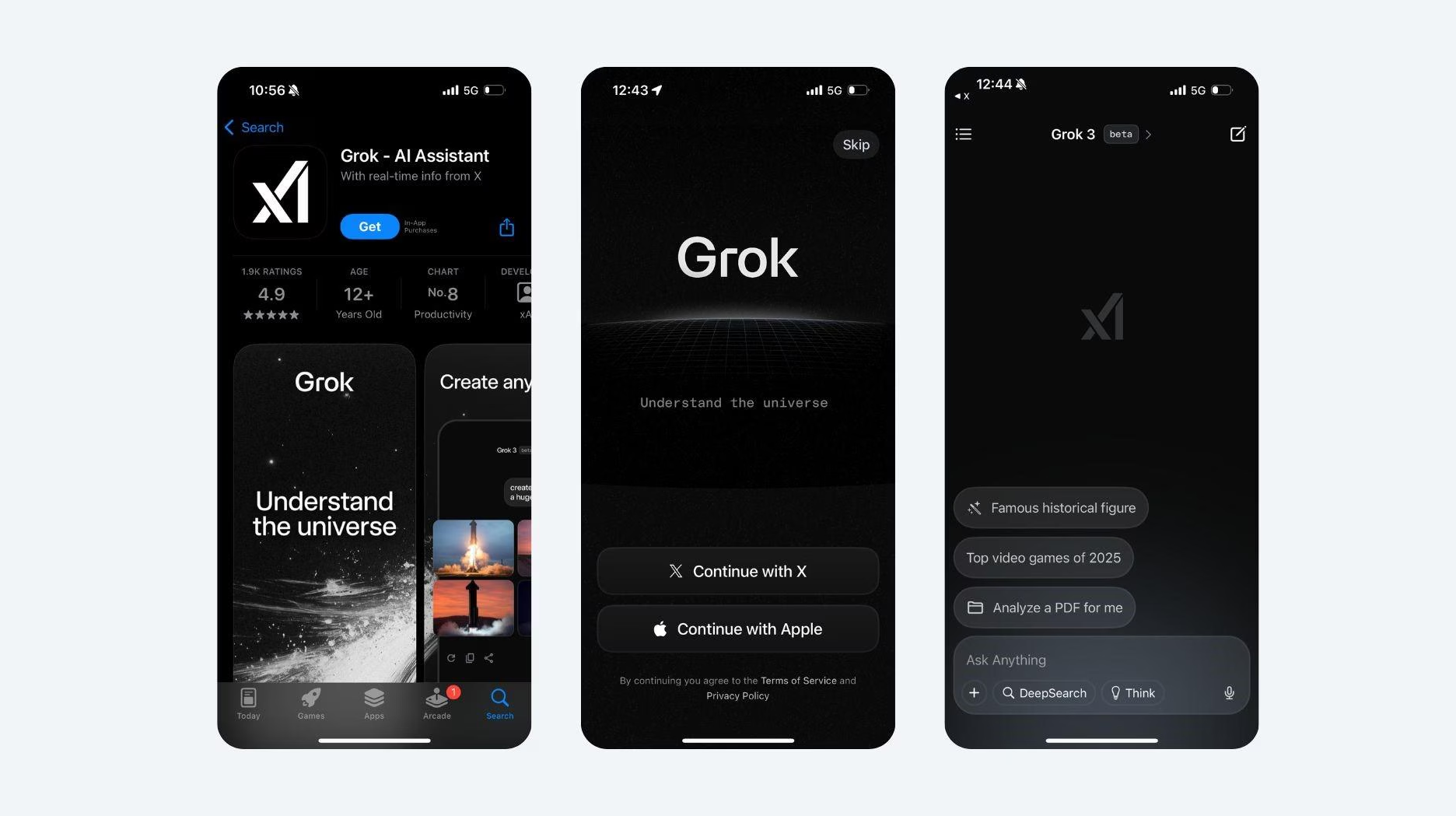

自从 Elon Musk 宣布推出由 xAI 团队打造的人工智能助手 Grok 以来,这款AI工具迅速成为科技圈的焦点。从接入X平台实时数据到主打“敢说真话”的个性标签,Grok 展现出了与主流AI不同的风格。但你是否好奇,支撑这一切的技术基础到底是什么?它与传统 AI 模型有什么不同?本文将从技术角度揭示 Grok 背后的原理和AI逻辑。

一、Grok 是什么?先从架构谈起

Grok 是由 xAI(Elon Musk 创立的AI公司) 开发的大型语言模型(LLM),与 ChatGPT、Claude、Gemini 等类似,属于通用型AI助手。其核心运行逻辑基于深度学习中的 Transformer 架构,这是目前几乎所有主流自然语言处理模型的技术基石。

据 Musk 透露,Grok 使用的是“Grok-1”及其后续版本,规模与 GPT-3.5/GPT-4 相近,具备多百亿参数,支持上下文理解、多轮对话、代码生成等常见AI能力。

二、AI逻辑核心:基于Transformer的语言理解

Grok 的核心工作机制与其他语言模型类似,依赖 Transformer 神经网络结构,进行以下几个关键步骤:

-

文本编码(Tokenization)

所有输入的文字会被转化成一系列“Token”,即模型可以理解的最小语言单位。 -

位置嵌入(Positional Encoding)

因为语言是有顺序的,Grok 会通过位置编码让模型理解词语的先后关系。 -

自注意力机制(Self-Attention)

每个词在上下文中的“重要性”被动态计算,使模型能够理解句子中的语义依赖。 -

多层神经网络迭代理解

经过多轮变换与计算,模型逐渐生成对输入的深层次语义理解,并据此生成回答或继续对话。

这些过程都运行在高性能GPU集群或专用AI芯片上,支持实时推理。

三、与传统LLM的区别:实时性与平台集成

Grok 的显著不同之处是它能实时接入 X 平台的社交数据流。这一功能背后反映了它的两个技术特征:

-

与外部数据接口动态融合

与大多数LLM只能依赖训练语料不同,Grok 可实时调用X平台数据API,使其能“看到”世界上正在发生的事情。 -

上下文增强引擎

在生成回复前,Grok 会“检索”最近的X帖子或相关新闻,将其作为额外上下文输入,从而增强其时效性与相关性。这种机制被称为 Retrieval-Augmented Generation(RAG),目前在AI界已被广泛采用。

四、幽默感与“态度”是设计选择,不是技术限制

Grok 之所以显得“有脾气”,是因为它的输出风格在训练阶段就被设定为更具人类表达特征。这种“个性化”并非技术限制,而是一种 微调(Fine-tuning)策略。

通过人为构造的训练数据,开发者可以让 Grok 更加幽默、直接、甚至带有讽刺意味。与传统AI强调中立与谨慎不同,Grok 主打“说真话”、“敢吐槽”,这是它产品定位的一部分。

五、安全与伦理控制:内容过滤系统也不可忽视

尽管 Grok 较为“自由”,但它仍然配备了内容审核与安全控制系统。这些系统通常包括:

-

关键词屏蔽与分类器过滤

-

毒性与偏见检测模块(基于机器学习模型判断输出内容是否违反政策)

-

人类反馈机制(RLHF),用于不断优化模型行为

在实际部署中,Grok 的“边界”仍然受到平台政策和用户体验需求的制约。

总结

Grok 背后的AI逻辑和技术架构,与当前最先进的语言模型一脉相承,包括Transformer架构、RAG机制、Fine-tuning个性化以及实时数据接入能力。它的特别之处,不仅在于技术实现的“速度”与“个性”,更在于它大胆地将AI嵌入了实时社交平台语境中。

这款AI不是“魔法”,而是众多AI工程进步叠加下的产物。未来,它的发展方向仍将受到技术演进、伦理审视与用户反馈的共同驱动。